type

status

data

slug

summary

tags

category

password

icon

AI大模型场景下智能计算技术选型分析

摘 要:

随着ChatGPT的诞生,AI大模型相关的产品和服务呈爆发式增长,国内互联网企业和运营商等纷纷加入“百模大战”。现有云平台中智能服务器采用传统GPU配置规格,无法满足大模型训练所需要的高性能算力和卡间互联带宽需求。本文主要研究扣卡模组形态的智能计算芯片技术,以及整机服务器的散热技术等内容,为后续建设智算中心提供选型依据。

Keyword:

智算中心;模型训练;扣卡模组机型;液冷散热;

人工智能(AI)技术是数字经济的核心驱动力。各国政府均在布局AI领域的全栈能力,并出资引导建设智能算力基础设施。我国也已进入智能化时代。“十四五”期间,各部委积极推动智能计算中心(简称智算中心)的建设和发展,旨在为AI应用提供公共算力服务。

智算中心是以GPU等智能计算芯片为核心、集约化建设的新型算力基础设施,提供软硬件全栈环境,主要承载模型训练、集中推理和多媒体渲染等业务,支撑各行业数智化转型升级。

1 AI大模型

生成式人工智能(AIGC)可谓是现阶段最热门的AI大模型。AIGC的前身是Open AI公司发布的通用人工智能网络GPT3,拥有1 750亿个参数量和45 TB的预训练数据量,其后基于GPT3发布商业化产品Chat GPT。Chat GPT可以回答问题、写诗、作词,甚至可以创作论文、音乐和电视剧等,在部分领域的能力甚至超越人类的基准水平。

AI大模型计算主要包含模型预训练、模型微调和模型推理3个步骤。模型预训练阶段进行算法架构搭建,基于大数据集对模型进行自监督式训练,生成基础大模型;模型微调阶段基于小数据集和RLHF等对模型进行调优和对齐,生成行业大模型或垂类模型;模型推理阶段基于用户调用需求,输出计算结果。

GPT类AI大模型属于大规模语言模型,参数量巨大,对算力的需求呈指数级的增长。训练模型所需的时间与消耗的资源成反比,训练时长越短,所需消耗的资源量越大。据估算,3个月内训练出一个GPT3模型,需要消耗3 000多张单卡算力不小于300 TFLOPS(半精度FP16)的GPU卡,而如果想在1个月内训练出GPT3模型,则需要10 000多张同类型GPU卡。同时,推理此类模型也无法在1张GPU卡进行,最少需要8卡同时进行推理才能保证延迟在1秒以内。

随着语言类模型的大获成功,相关技术方法被引入图像、视频和语音等多个应用场景。如构建用于目标检测和图像分类等的视觉类大模型,可广泛应用于自动驾驶和智慧城市等领域。多模态大模型可以同时覆盖众多场景,与此同时,参数规模进一步迅速增长,可达百万亿级别,对智算中心的算力、数据和网络等能力提出了更高的要求。

2 智能计算芯片选型分析

GPU芯片按形态可以分为PCIe标卡和扣卡模组两种。两种形态的GPU与CPU之间通信均通过PCIe总线。CPU会参与训练中的数据集加载和处理等工作,主要差异在于GPU的卡间通信方式和卡间互联带宽不同。

对于大多数标准的服务器来讲,受服务器PCIe总线设计和插槽数量的限制,通常1台服务器内部最多可以部署8张GPU芯片。

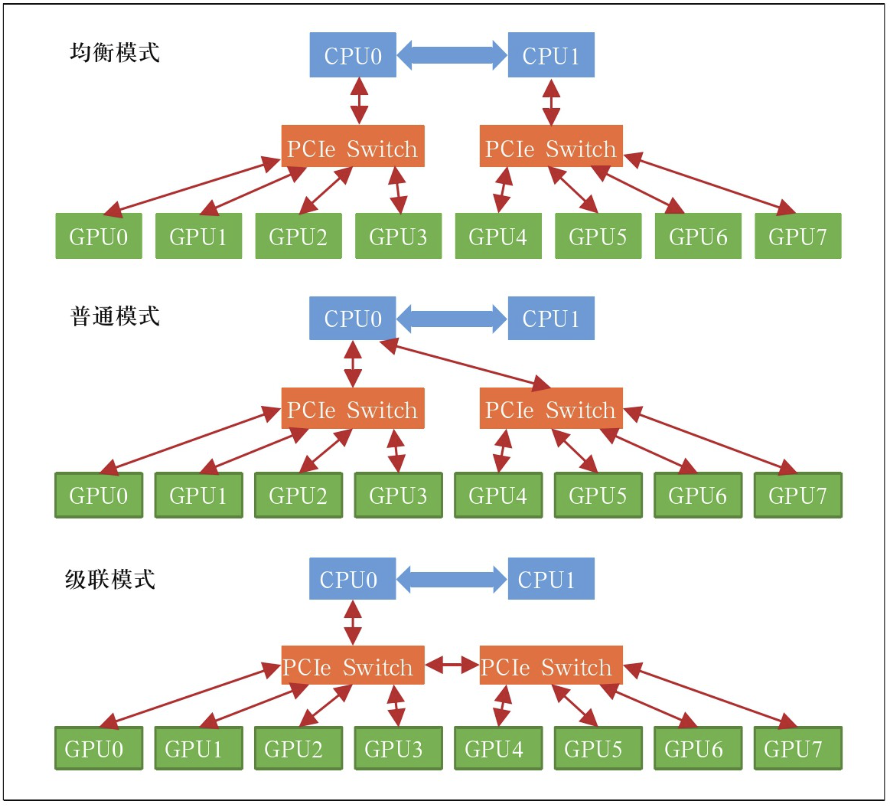

2.1 PCIe标卡

采用PCIe标卡形态的GPU芯片,服务器内部8卡之间通过PCIe Switch进行连接。PCIe Switch是一种用于拓展PCIe接口的芯片,可以实现1个PCIe接口对接多个PCIe设备,1台部署8张GPU卡的服务器,1个PCIe Switch可以对接4张GPU卡,服务器设置2个PCIe Switch可以实现8张卡的互联通信。采用PCIe 4.0协议,卡间双向带宽为64 Gbit/s;采用PCIe 5.0协议,卡间双向带宽为128 Gbit/s。具体卡间通信方式根据业务场景和部署的模型不同,有3种模式可选,具体如图1所示。

第1种为均衡模式。PCIe Switch分别通过2个CPU进行连接,远端GPU卡之间通过PCIe Switch跨CPU进行通信。这种模式下,CPU利用率最大化,可以提供更大的上行链路带宽,但远端卡间通信受限于CPU之间的UPI通信带宽。均衡模式可以保证每个GPU的性能均衡,适用于公有云场景,以及CPU和GPU同时参与任务的算法模型,如Inception3等。

第2种为普通模式。PCIe Switch通过同一个CPU进行连接,远端GPU卡之间无需跨CPU之间进行UPI通信,可以提供较大的点对点卡间带宽,并且CPU到GPU之间有2条PCIe通道,吞吐量高。普通模式可以提供较好的GPU与CPU之间的通信性能,适用于CPU参与较多任务的通信密集型算法模型,如Resnet101和Resnet50等。

第3种为级联模式。PCIe Switch不通过CPU直接连接,远端GPU卡之间直接通过PCIe Switch级联通信,点对点卡间带宽最大,但CPU到GPU之间只有1条PCIe通道,吞吐量相对较小。级联模式可以为大参数量模型提供最优的点对点卡间通信性能,适用于CPU参与较少任务的计算密集型算法模型,如VGG-16等。

图1 PCIe标卡远端卡间通信模式

PCIe标卡服务器机型主要用于单机单卡或单机多卡训练场景。3种卡间通信模式支持按需配置,对CPU核心数和虚拟化要求较高的云化场景通常选用均衡模式。在分布式训练场景下,不同算法模型选用合适的通信模式可获得最优的GPU线性加速比,在有限条件下可实现GPU卡的最大化利用。

2.2 扣卡模组

采用扣卡模组形态的GPU芯片,服务器内部的8张卡集成在1块基板上,GPU卡间可以实现端到端全互联。扣卡模组服务器机型搭配外部的高速互联网络可有效满足大规模的多机多卡并行训练任务。

扣卡模组基板主要分为SXM和OAM两种标准。SXM是独家私有标准,需要配合私有的NVLink接口实现卡间高速互联;OAM是开放模组标准,对外提供标准接口,打破对独家的供应依赖。OAM提供的接口具有高度灵活性,卡间互联可有多个变种拓扑结构。

2.2.1 SXM扣卡模组

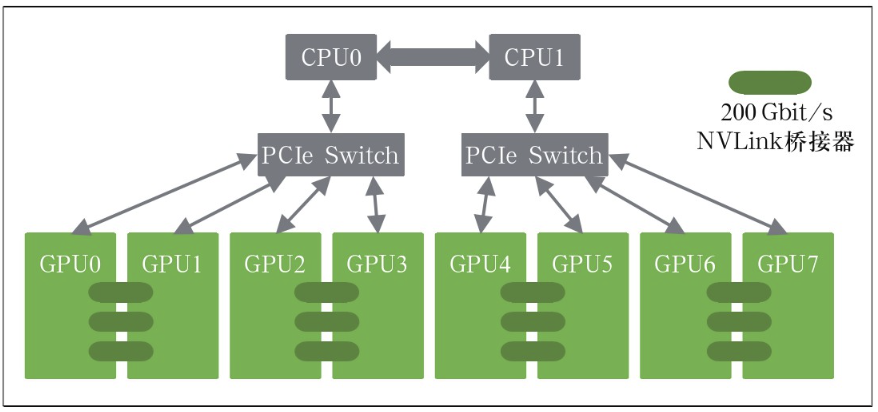

NVLink是为解决PCIe总线带宽限制提出的一种GPU互连总线协议。目前NVLink协议演进到第4代,每张GPU最大支持18个NVLink连接,GPU卡之间双向带宽可达900 Gbit/s。

PCIe标卡服务器可通过选配NVLink桥接器,实现相邻2张卡之间的高速互联,采用桥接器可实现的最高双向带宽为600 Gbit/s。但NVLink桥接器无法实现服务器内部所有GPU卡之间的全互联,在大模型训练场景下仍无法满足多机多卡之间的并行通信需求。采用NVLink桥接器的卡间互联架构示意如图2所示。

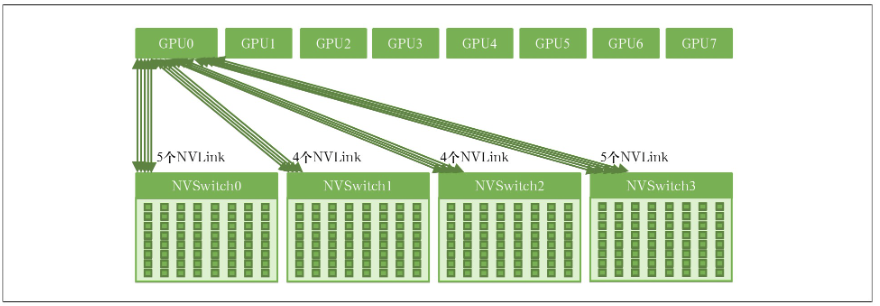

SXM扣卡模组是芯片厂商自有设计标准,基板不仅集成了8张GPU卡,同时还集成了NVSwitch芯片,每个NVSwitch(第4代)都有64个NVLink网络端口,可以将8张GPU卡全部连接起来,是实现8卡之间端到端全互联的关键组件。卡间互联架构示意如图3所示。

2.2.2 OAM扣卡模组

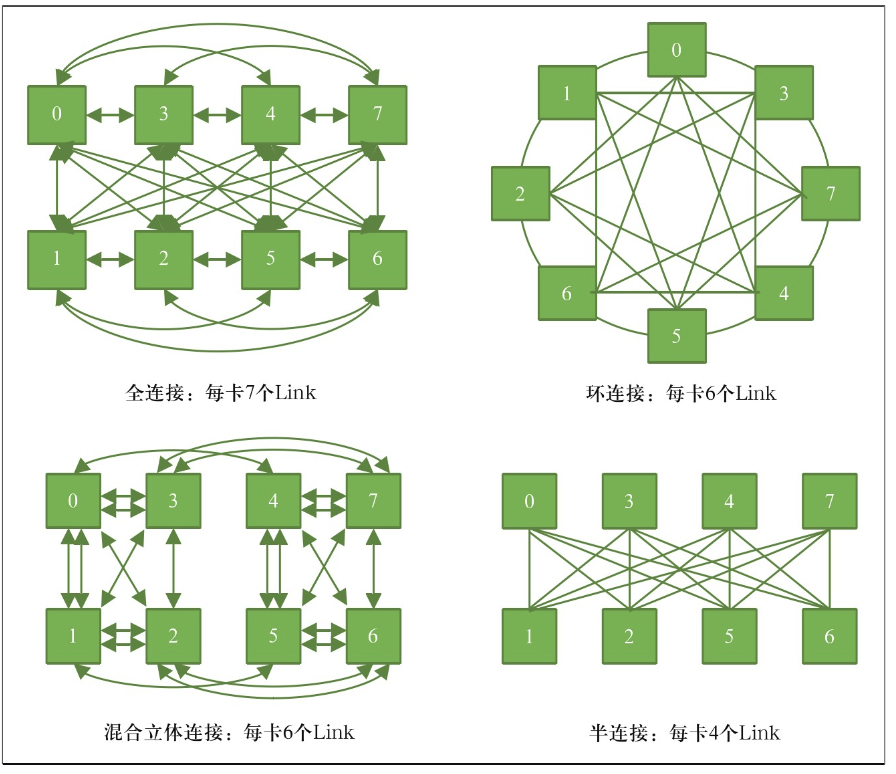

OAM是开源组织OCP定义的用来指导GPU模组系统设计的标准。其对标SXM模组,可以帮助GPU服务器实现更好的类似NVLink的卡间互联通信。目前国产GPU服务器普遍采用OAM扣卡模组形态。

图2 PCIe标卡采用NVLink桥接器的卡间互联架构示意图

图3 SXM扣卡模组卡间互联架构示意图

OAM标准定义了GPU服务器内部的扣卡模组、主板、机箱、供电、制冷、I/O交互和系统管理等一系列规范。不同厂商设计的扣卡模组只要符合OAM标准,卡间互联通信有多种方案可以灵活选择。典型的有全连接、混合立体连接、环连接和半连接等。卡间互联架构示意如图4所示。OAM除了需要考虑卡间互联链路以外,还需要同步考虑与CPU、网卡等部件的连接,以及预留对外的扩展端口。全连接是未来趋势,但当前国产GPU芯片产品设计定位和方式不同,多采用混合立体连接和半连接方式。

当前,AI大模型逐步由单模态向多模态转变,涉及视觉问答、情感分析、跨媒体检索和生成任务等多种应用场景。多模态模型算法更加复杂、数据规模更加庞大。扣卡模组形态的GPU芯片,卡间互联通信不受PCIe接口带宽限制,可提供更高的卡间带宽和更低的传输时延,在多模态大模型训练应用中可以提供更出色的性能。

3 智能计算服务器散热选型分析

扣卡模组机型和PCIe标卡机型的整机服务器散热方式选型需结合服务器功耗情况、内部构造特点和服务器整机厂家支持情况综合决定。

图4 OAM扣卡模组卡间互联架构示意图

首先,扣卡模组机型功耗较高,PCIe标卡机型功耗相对较低,配置8卡的扣卡模组机型整机功耗约为7~11 k W,而PCIe标卡机型整机功耗约为3~4 k W。其次,扣卡模组插卡在同一个平面上,更适合冷板结构设计,而PCIe标卡采用独立竖插方式,每个插卡需要单独设计冷板,且冷板间互联结构复杂。另外,从厂家支撑情况来看,扣卡模组机型整机服务器厂家大多具备液冷方案,而PCIe标卡机型的整机服务器厂家液冷方案较少。

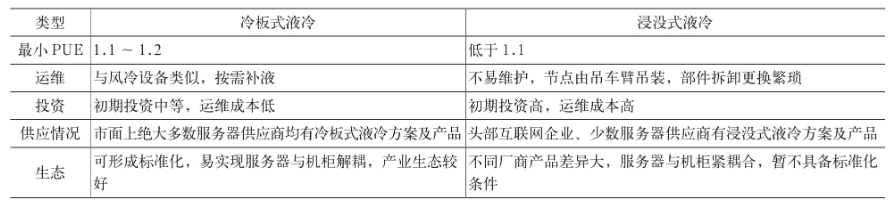

液冷散热方式又分为冷板式液冷和浸没式液冷两种,具体差异见表1。

表1 服务器液冷选型对比

表2 冷板式液冷机柜交付方式对比

相较浸没式液冷技术,当前冷板式液冷在初始投资成本、网络运维模式、生态成熟度、机房改造难度和工程实施进度等方面更具有优势。

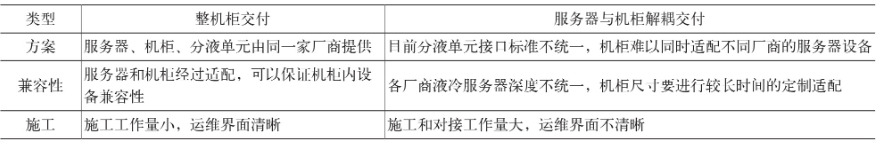

同时,冷板式液冷服务器存在整机柜交付和服务器与机柜解耦交付两种方式,具体差异见表2。

考虑液冷技术特点、竞争生态和运维界面等问题,在尚未建立机柜解耦标准的情况下,更适合选择整机柜交付方式。

综上分析,PCIe标卡机型采用风冷散热方式即可满足使用需求,使用数据中心通用机柜安装,无需整机柜配置。扣卡模组机型需采用液冷散热方式,结合当前技术和生态情况,优选冷板式液冷和整机柜交付模式。

4 结束语

智算中心在大模型训练、AI+视频、自动驾驶和智慧城市等业务场景都有较大的智能算力需求和发展空间。目前国内智算中心建设如火如荼,全国有30多个城市已建成或正在建设智算中心。但建设智算中心与传统云计算平台不同,在计算、存储、网络、应用、平台等各方面都有较高要求和挑战,后续将持续关注并研究智算全栈技术,为建设技术领先、绿色节能、服务全局的大型智算中心提供可行性方案。

参考文献

[1] OCP OAI Workstreams.Open accelerator module design specification v1.5[S].2021.